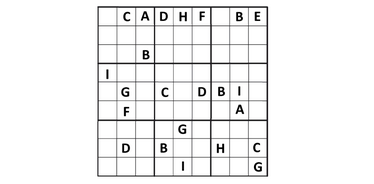

Forscher der Universität Colorado (Anirudh Maiya, Razan Alghamdi, Maria Leonor Pacheco, Ashutosh Trivedi, Fabio Somenzi) testeten LLMs an 6×6 Sudoku-Rätseln. Neue Forschungen zeigen, dass moderne Sprachmodelle logische Aufgaben lösen können, aber noch nicht in der Lage sind, ihren Denkprozess klar zu erklären:

- In der Studie wurden 2.293 einzigartige Rätsel verwendet.

- Fünf Modelle wurden getestet: vier Open-Source-Modelle (Gemma, Mistral und zwei Versionen von Llama) und ein geschlossenes Modell von OpenAI (o1-preview).

- Die Aufgaben reichten von einfach bis „teuflisch“.

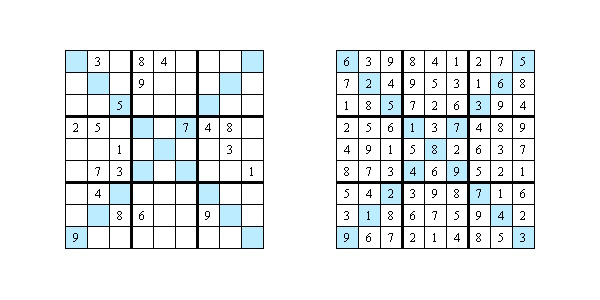

Ergebnisse:

- Die Open-Source-Modelle lösten weniger als 1 % der Rätsel, während OpenAI deutlich besser abschnitt – mit 65 % richtigen Lösungen.

- Bei einfachen Rätseln (Easy und Medium) erreichte OpenAI 100 % Genauigkeit. Bei den schwierigsten Sudokus („Diabolical“) sank die Genauigkeit auf 40 %.

Die Grenzen der KI

Die Autoren der Studie untersuchten, wie die KI ihre Schritte erklärt. Sie wählten 20 Rätsel aus und ließen Experten die Antworten nach drei Kriterien bewerten:

- Begründung. Nur in 5 % der Fälle konnte das Modell erklären, warum es eine bestimmte Zahl wählte. In den übrigen Fällen listete es lediglich allgemeine Sudoku-Regeln auf, die nicht relevant waren.

- Klarheit. Nur 7,5 % der Erklärungen waren klar und kohärent; die übrigen waren vage, widersprüchlich oder übersprangen Schritte.

- Praktischer Nutzen. Nur 2,5 % der Erklärungen halfen, die eigentliche Lösungsstrategie zu verstehen.

Warum Antworten allein nicht ausreichen

Künstliche Intelligenz wird heute zunehmend in Medizin, Wirtschaft und Recht eingesetzt. Wenn ein Modell seinen Denkprozess jedoch nicht transparent erklären kann, wird der Einsatz in kritischen Bereichen riskant. Bei Aufgaben wie einer Diagnose oder einer juristischen Entscheidung kann die Erklärung wichtiger sein als die Antwort selbst. Die Forscher betonen, dass Modelle, um wirklich nützliche Partner zu werden, nicht nur richtige Antworten finden, sondern auch komplexe Denkprozesse in