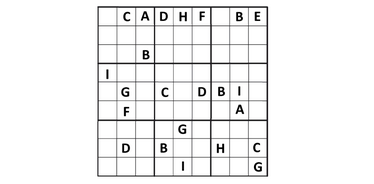

นักวิจัยจากมหาวิทยาลัยโคโลราโด (Anirudh Maiya, Razan Alghamdi, Maria Leonor Pacheco, Ashutosh Trivedi, Fabio Somenzi) ได้ทดสอบ LLM กับปริศนา 6×6 ซูโดกุ งานวิจัยล่าสุดชี้ว่า โมเดลภาษาสมัยใหม่สามารถแก้ปัญหาเชิงตรรกะได้ แต่ยังไม่สามารถอธิบายเหตุผลได้อย่างชัดเจน:

- งานวิจัยนี้ใช้ปริศนาที่ไม่ซ้ำกัน 2,293 ชุด

- ทดสอบโมเดลทั้งหมดห้าแบบ: แบบโอเพนซอร์สสี่ตัว (Gemma, Mistral และ Llama สองเวอร์ชัน) และแบบปิดจาก OpenAI (o1-preview)

- ปริศนามีระดับความยากแตกต่างกัน ตั้งแต่ง่ายไปจนถึง "ยากสุดๆ"

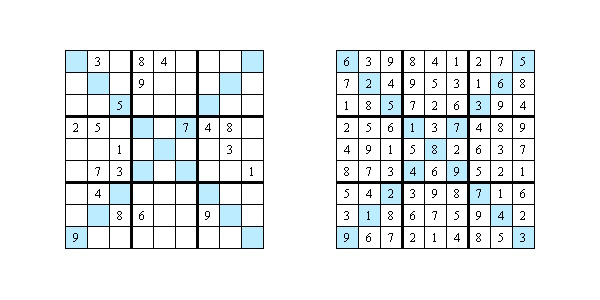

ผลลัพธ์:

- โมเดลโอเพนซอร์สแก้ได้ไม่ถึง 1% ขณะที่ OpenAI ทำได้ดีกว่ามาก – แก้ถูกต้อง 65%

- สำหรับปริศนาง่าย (ระดับ Easy และ Medium) OpenAI มีความถูกต้อง 100% แต่สำหรับซูโดกุที่ยากที่สุด ("Diabolical") ความถูกต้องลดลงเหลือ 40%

ขีดจำกัดของความสามารถ AI

ผู้เขียนงานวิจัยได้ตรวจสอบว่า AI อธิบายขั้นตอนการแก้อย่างไร พวกเขาเลือกปริศนา 20 ชุด และให้ผู้เชี่ยวชาญประเมินคำตอบตามเกณฑ์สามข้อ:

- เหตุผลประกอบ เพียง 5% ของกรณีที่โมเดลสามารถอธิบายได้ว่าทำไมถึงเลือกตัวเลขนั้น ที่เหลือเพียงแค่ยกกฎทั่วไปของซูโดกุที่ไม่เกี่ยวกับปริศนานั้น

- ความชัดเจน มีเพียง 7.5% ของคำอธิบายที่ชัดเจนและสอดคล้องกัน ส่วนใหญ่กำกวม ขัดแย้ง หรือข้ามขั้นตอน

- ประโยชน์เชิงปฏิบัติ มีเพียง 2.5% ของคำอธิบายที่ช่วยให้เข้าใจกลยุทธ์ในการแก้ปริศนา

ทำไมคำตอบเพียงอย่างเดียวไม่เพียงพอ

ปัจจุบัน AI ถูกนำมาใช้มากขึ้นในด้านการแพทย์ ธุรกิจ และกฎหมาย แต่ถ้าโมเดลไม่สามารถอธิบายเหตุผลอย่างโปร่งใส การใช้ในสาขาสำคัญจะเป็นความเสี่ยง สำหรับกรณีอย่างการวินิจฉัยโรคหรือการตัดสินทางกฎหมาย คำอธิบายอาจสำคัญกว่าคำตอบเสียอีก นักวิจัยชี้ว่า หากต้องการให้โมเดลเป็นผู้ช่วยที่มีประโยชน์จริง จะต้องฝึกให้ไม่เพียงแต่หาคำตอบที่ถูกต้อง แต่ยังต้องแปลงกระบวนการคิดที่ซับซ้อนให้อยู่ในรูปแบบที่มนุษย์เข้าใจได้

งานวิจัย: https://arxiv.org/pdf/2505.15993