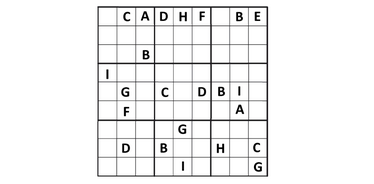

Các nhà nghiên cứu từ Đại học Colorado (Anirudh Maiya, Razan Alghamdi, Maria Leonor Pacheco, Ashutosh Trivedi, Fabio Somenzi) đã kiểm tra LLM với các câu đố 6×6 sudoku. Nghiên cứu mới cho thấy các mô hình ngôn ngữ hiện đại có thể giải quyết các bài toán logic nhưng vẫn chưa thể giải thích rõ ràng quá trình suy luận:

- Nghiên cứu sử dụng 2.293 câu đố độc nhất.

- Đã thử nghiệm năm mô hình: bốn mã nguồn mở (Gemma, Mistral và hai phiên bản của Llama) và một mô hình đóng của OpenAI (o1-preview).

- Các câu đố có độ khó khác nhau, từ dễ đến "ác quỷ".

Kết quả:

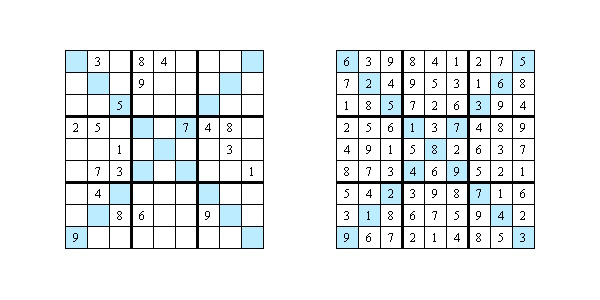

- Các mô hình mã nguồn mở chỉ giải được dưới 1% câu đố, trong khi OpenAI đạt 65% lời giải đúng.

- Với các câu đố đơn giản (Easy và Medium), OpenAI đạt độ chính xác 100%. Với sudoku khó nhất ("Diabolical"), độ chính xác giảm xuống còn 40%.

Giới hạn khả năng của AI

Các tác giả nghiên cứu đã xem xét cách AI giải thích các bước của mình. Họ chọn 20 câu đố và nhờ các chuyên gia đánh giá câu trả lời dựa trên ba tiêu chí:

- Lý do. Chỉ trong 5% trường hợp, mô hình mới giải thích được tại sao chọn số đó. Trong hầu hết các trường hợp khác, nó chỉ liệt kê các quy tắc sudoku chung chung không liên quan.

- Sự rõ ràng. Chỉ 7,5% lời giải thích rõ ràng và mạch lạc, số còn lại thì mơ hồ, mâu thuẫn hoặc bỏ qua các bước.

- Giá trị thực tiễn. Chỉ 2,5% lời giải thích thực sự giúp hiểu chiến lược giải sudoku.

Tại sao chỉ có đáp án là chưa đủ

Ngày nay, AI ngày càng được sử dụng trong y học, kinh doanh và pháp luật. Nhưng nếu mô hình không thể giải thích quá trình suy luận một cách minh bạch, việc sử dụng trong các lĩnh vực quan trọng sẽ trở nên rủi ro. Trong các trường hợp như chẩn đoán hoặc phán quyết pháp lý, lời giải thích đôi khi quan trọng hơn cả câu trả lời. Các nhà nghiên cứu nhấn mạnh rằng để AI trở thành đối tác thực sự hữu ích, nó phải không chỉ tìm ra đáp án đúng mà còn phải chuyển các bước suy luận phức tạp thành ngôn ngữ dễ hiểu với con người.

Nghiên cứu: https://arxiv.org/pdf/2505.15993