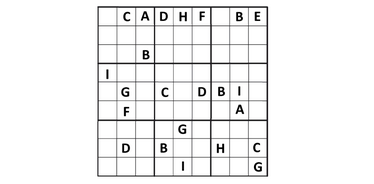

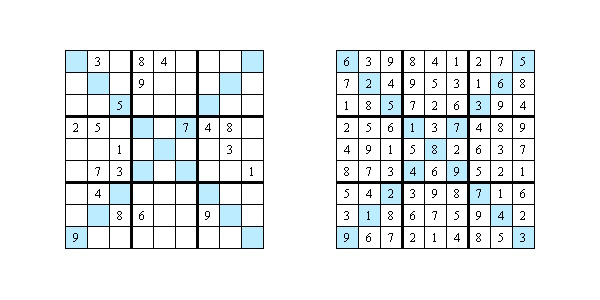

Des chercheurs de l’Université du Colorado (Anirudh Maiya, Razan Alghamdi, Maria Leonor Pacheco, Ashutosh Trivedi, Fabio Somenzi) ont testé les LLM sur des grilles de sudoku 6×6. Des études récentes montrent que les modèles de langage modernes savent résoudre des problèmes logiques mais ne parviennent pas encore à expliquer clairement leur raisonnement :

- 2 293 grilles uniques ont été utilisées dans l’étude.

- Cinq modèles ont été testés : quatre open source (Gemma, Mistral et deux versions de Llama) et un modèle propriétaire d’OpenAI (o1-preview).

- Les grilles variaient en difficulté, de simples à « diaboliques ».

Résultats :

- Les modèles open source ont résolu moins de 1 % des grilles, tandis qu’OpenAI a atteint 65 % de solutions correctes.

- Pour les grilles simples (Easy et Medium), OpenAI a atteint 100 % de précision. Pour les plus difficiles (« Diabolical »), la précision est tombée à 40 %.

Les limites de l’IA

Les auteurs de l’étude ont examiné la manière dont l’IA explique ses étapes. Ils ont sélectionné 20 grilles et demandé à des experts d’évaluer les réponses selon trois critères :

- Justification. Seulement 5 % des cas comportaient une explication claire du choix d’un chiffre. Les autres se limitaient à énumérer des règles générales de sudoku sans rapport avec la grille.

- Clarté. Seuls 7,5 % des explications étaient claires et cohérentes. Les autres étaient vagues, contradictoires ou sautaient des étapes.

- Utilité pratique. Seulement 2,5 % des explications aidaient réellement à comprendre la stratégie de résolution.

Pourquoi les réponses ne suffisent pas

L’IA est de plus en plus utilisée en médecine, en affaires et en droit. Mais si un modèle ne peut pas expliquer son raisonnement de façon transparente, son utilisation dans des domaines critiques devient risquée. Dans des cas comme un diagnostic ou une décision juridique, l’explication peut être plus importante que la réponse elle-même. Les chercheurs soulignent que pour devenir de véritables partenaires utiles, les modèles doivent non seulement trouver la bonne réponse mais aussi traduire des raisonnements complexes en langage compréhensible par l’humain.

Étude : https://arxiv.org/pdf/2505.15993